Le biceps présidentiel a-t-il été artificiellement gonflé ? C’est ce que croient depuis la semaine dernière de nombreux internautes scrutant les muscles saillants et veines gonflées d’Emmanuel Macron boxant un sac de frappe. Si la photographe officielle de l’Elysée, autrice du cliché, a balayé ces doutes, la suspicion est là. C’est ce que relatent les commanditaires de cette étude, en version intégrale ici.

« Au-delà de leur dimension souvent ludique, ces créations que l’on nomme aussi hypertrucages véhiculent régulièrement des fake news à grande échelle. Si les personnalités politiques et les célébrités en sont fréquemment la cible – de Taylor Swift à Volodymyr Zelensky en passant tout récemment par Ursula von der Layen -, les anonymes n’y échappent pas, comme l’a montré le cas d’adolescentes espagnoles victimes à l’automne dernier de montages photos dégradants. » commente Léa Paolacci, responsable de cette étude.

Qu’ils soient créés à des fins ludiques ou de désinformation, ces contenus basés sur le détournement d’images et de voix inquiètent de plus en plus. Une commission mixte de sénateurs et de députés se réunira d’ailleurs aujourd’hui, mardi 26 mars, afin d’étudier un projet de loi visant à sécuriser et réguler l’espace numérique (SREN), qui contient plusieurs articles consacrés à la lutte contre les deepfakes, notamment lorsqu’ils ont un caractère pornographique.

Distinguer le vrai du faux : une difficulté pour les deux tiers des Français

La majorité reconnait ne pas se sentir en capacité de repérer une image ou une vidéo entièrement générées par l’intelligence artificielle. Seul un tiers (33%) des Français se sentent capables de détecter un deepfake et à peine 6% en sont certains, signe de la grande incertitude qui les habite.

Les jeunes et les hommes sont plus confiants : 55% des 18-24 ans pensent y arriver contre 28% des plus de 35 ans, et 40% des hommes contre 28% des femmes.

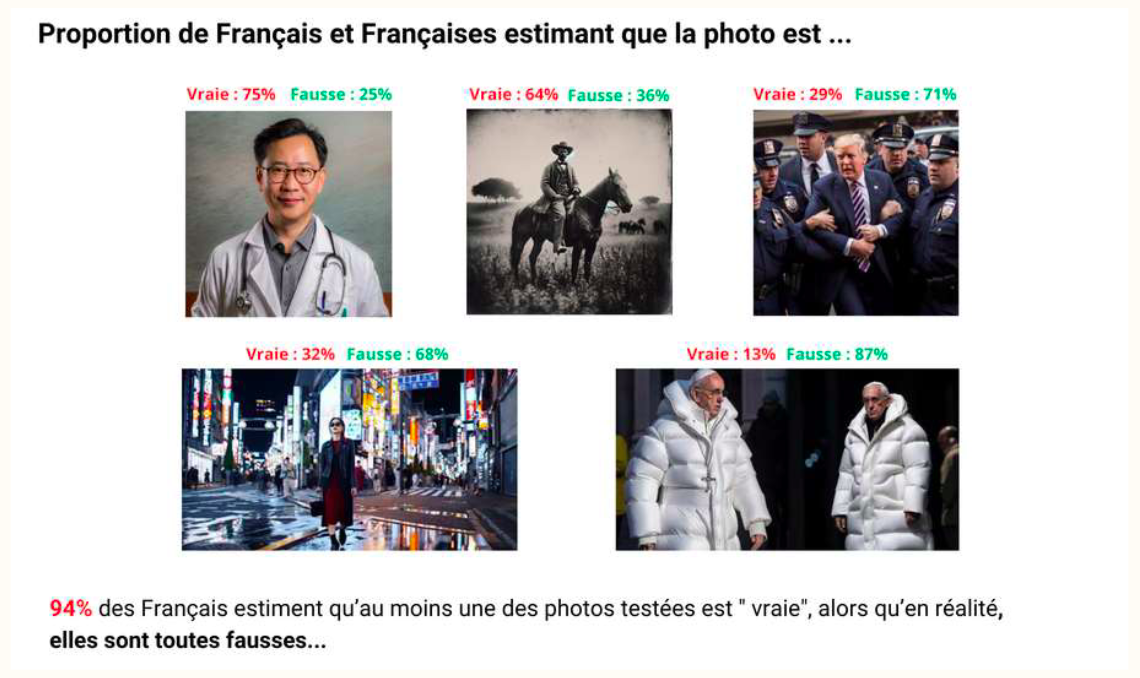

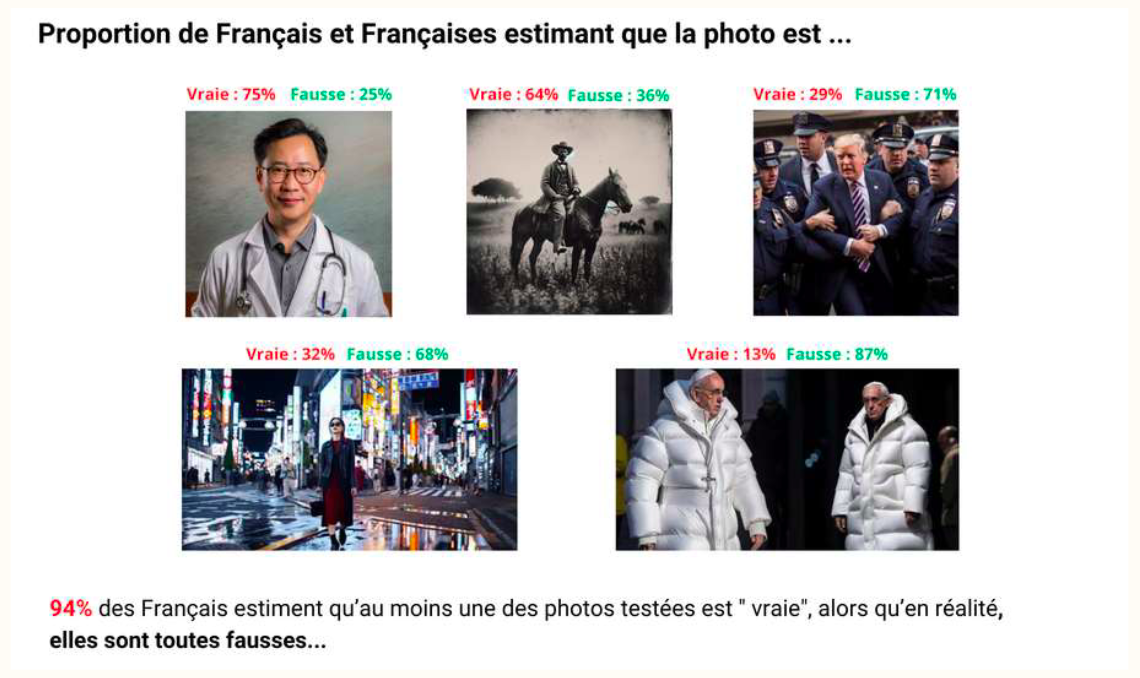

Confrontés à 5 images créées par un algorithme, plus de 9 Français sur 10 ont cru en l’authenticité d’au moins l’une d’elles.

Confrontés à 5 images créées par un algorithme, plus de 9 Français sur 10 ont cru en l’authenticité d’au moins l’une d’elles. Un test de l’IFOP démontre la difficulté à discerner le vrai du faux. Sur 5 images montrées, toutes générées par l’IA, 75% ont cru à l’authenticité d’un portrait de médecin et 64% à celle d’une vieille photo d’homme à cheval. 32% ont par ailleurs été dupés par une scène de rue à Tokyo tirée d’une vidéo d’Open AI, 29% par un cliché de Donald Trump entouré de policiers et 13% par l’image multidiffusée du pape François en doudoune blanche.

Finalement, 94% ont tenu pour réelle au moins une des images créées par un algorithme.

Avertir le public de la nature d’une image apparait comme une impérative nécessité. Face aux risques de désinformation, une écrasante majorité (90%) souhaite une mention identifiant les deepfakes comme artificiels. Une demande plus forte chez les plus de 35 ans (93%) que parmi les 18-24 ans (79%)

69% des Français ont entendu parler des deepfakes mais seuls 30% savent précisément de quoi il retourne.

Les plus jeunes sont les plus avertis de l’existence et de la nature des deepfakes. Les jeunes et les hommes sont mieux informés : 83% des 18-24 ans en ont connaissance et 50% une vision claire, contre respectivement 66% et 15% chez les seniors. 37% des hommes disent en avoir une idée précise, soit 13 points de plus que les femmes (24%).

Des indices difficiles à détecter

Si certains éléments sont (encore) de nature à trahir une image générée par l’IA, ils apparaissent comme difficilement discernables pour nombre de personnes. 59% des répondants jugent assez simple de voir un mouvement de lèvres peu naturel. Seul un tiers considère facile deremarquer un clignement d’yeux trop rare (33%) ou des mains mal reproduites (32%). Rides plates (29%), reflets de lunettes (25%), ombres imprécises (21%) ou pilosité incomplète (15%) sont d’autres signaux jugés peu aisés à déceler

1 Français sur 3 a déjà relayé de fausses infos

Volontaire ou non, le fait de relayer des fake news est une pratique relativement répandue dans la population.

Deepfakes et fake news servent la même cause de désinformation. 31% des sondés admettent avoir déjà diffusé des infos qui se sont révélées fausses, les jeunes (46%) plus que les autres. Les trois quarts des plus de 50 ans disent pour leur part ne jamais l’avoir fait.

Une moralité parfois douteuse

Utiliser l’IA à des fins de surveillance des citoyens ou pour déshabiller des personnes est jugé moralement acceptable par une part non négligeable des répondants.

Aucun des différents usages de l’IA présentés aux personnes interrogées n’est jugé acceptable par une majorité d’entre elles.

Les mieux tolérés sont la création artistique (42%) et les filtres retouchant les photos sur les réseaux sociaux (32%).

Plus inquiétant, 30% cautionnent la surveillance des citoyens contestataires. Déshabiller quelqu’un virtuellement pour s’amuser est approuvé par 9% en moyenne, chiffre qui grimpe à 26% chez les hommes âgés de moins de 35 ans.

13% des moins de 25 ans victimes de deepfakes

Plus de la moitié des Français redoutent d’être un jour victimes d’hypertrucages. 57% craignent d’être ciblés par des deepfakes, ce qui est déjà arrivé à 4% et même 13% des moins de 25 ans, gros consommateurs de réseaux sociaux.

Les jeunes sont les plus inquiets (64% des 18-24 ans) mais les autres générations ne sont pas sereines non plus (56% des plus de 25 ans font, eux aussi, part de leur inquiétude).

Les deepfake : ne menace pour 2027 ?

Les deux tiers des personnes interrogées appréhendent la diffusion de deepfakes lors de la prochaine élection présidentielle.

62% sont inquiets par la possibilité que des deepfakes perturbent la présidentielle de 2027, dont 16% en ont très peur. Les jeunes le sont moins (49% des moins de 25 ans) que les seniors (70% des plus de 65 ans)

En résumé

Les chiffres clés

- 69% des Français ont entendu parler des deepfakes ;

- 33% se sentent capable de détecter une image générée par l’intelligence artificielle ;

- Sur 5 images, toutes créées artificiellement, 94% des personnes interrogées ont cru à la véracité d’une au moins ;

- 57% des Français craignent d’être eux-mêmes victimes de deepfakes et 13% des moins de 25 ans disent que cela a déjà été leur cas ;

- 62% des répondants redoutent que les deepfakes perturbent la prochaine élection présidentielle.

Méthodologie

L’enquête a été menée auprès d’un échantillon de 2 191 personnes, représentatif de la population française âgée de 18 ans et plus, dont 551 jeunes de moins de 35 ans.

La représentativité de l’échantillon a été assurée par la méthode des quotas (sexe, âge, profession de la personne interrogée) après stratification par région et catégorie d’agglomération.

Les interviews ont été réalisées par questionnaire auto-administré en ligne du 5 au 8 mars 2024.